通用目标检测是计算机视觉的基本问题之一,在目标检测经典框架YOLO的基础上,阿里达摩院新推出了新框架DAMO-YOLO,兼顾速度与精度,已成为最新的SOTA。达摩院已宣布将该框架开源,并在魔搭社区上免费开放使用。

所谓目标检测,是让AI在图片中找到某些特定物体,不仅要识别这些对象的种类,还得标注出这些物体的位置。可以说,没有目标检测,自动驾驶等AI应用无从谈起。YOLO全称是You Only Look Once,只需要看一眼就可以识别出图中物体的类别和位置。从2016年提出以来,YOLO因其高效、精准成为了目标检测的经典算法框架,并不断演进,获得广泛使用。

目标检测示意

达摩院研究团队在YOLO基础上进行了一系列创新,对原有架进行了大幅的修改,形成了新框架DAMO-YOLO,创新包括:基于神经网络结构搜索技术(NAS)的高效检测骨干网络(backbone),更深的多尺度特征融合检测颈部(neck),精简的检测头结构(head),以及引入蒸馏技术进一步提升效果。其中,新骨干网络结构采用了阿里自研的MAE-NAS,这是一种启发式和免训练的NAS搜索方法,可以用于快速大范围搜索各种不同规模的骨干网络结构。由于这些创新和优化,DAMO-YOLO在严格限制时延的情况下显著提升了精度,成为YOLO框架中的新SOTA。

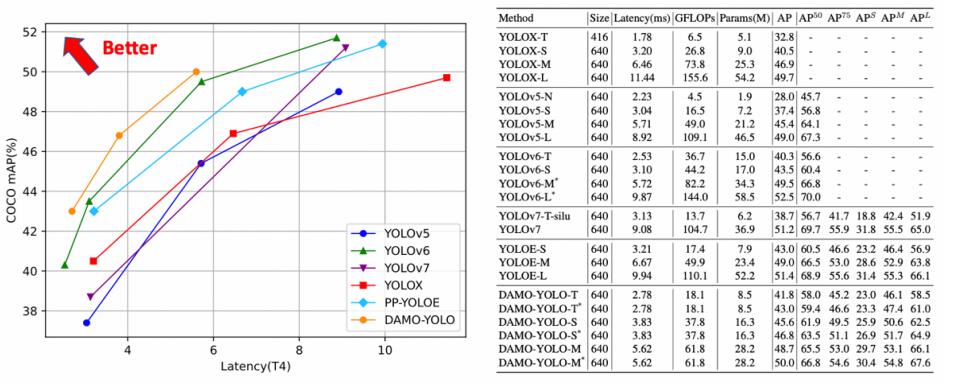

DAMO-YOLO和其他YOLO的性能对比

为了进一步提升实用性,DAMO-YOLO引入TinyNAS技术,使得用户可以根据硬件算力情况进行低成本的检测模型定制,提高硬件利用效率并且获得更高精度。模型之外,DAMO-YOLO还提供高效的训练策略以及便捷易用的部署工具,以便快速解决工业落地中的实际问题。目前,该框架已在AI模型社区魔搭ModelScope上线,支持快速调用,0代码可以体验模型效果,1行代码实现模型推理,10行代码实现模型调优。

使用入口:https://www.modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo/summary

代码地址:https://github.com/tinyvision/DAMO-YOLO

责编:hxq

〖免责申明〗本文仅代表作者个人观点,其图片及内容版权仅归原所有者所有。如对该内容主张权益请来函或邮件告之,本网将迅速采取措施,否则与之相关的纠纷本网不承担任何责任。